Infraestructures d’Aina

El projecte Aina es coordina des del Barcelona Supercomputing Center (BSC-CNS), un centre pioner que és referent en l’àmbit de la supercomputació. El superordinador MareNostrum 5 habilita el processament de dades massives i l’execució de models lingüístics avançats i pioners en el sector.

El superordinador té una capacitat de 314 petaflops i està ubicat a l’àrea de la UPC-Campus Nord-Barcelona Tech. MareNostrum 5 té una potència pre-exaescala 100 cops superior al MareNostrum 4. Un avanç que suposa una gran oportunitat per a l’execució de recursos i tecnologies del llenguatge que requereixen altes prestacions.

Gestió de dades, un esforç col·lectiu

En la tasca del desenvolupament de recursos lingüístics, Aina treballa amb dades textuals i de veu que rep gràcies a la col·laboració dels usuaris i d’altres recursos disponibles. De fet, el projecte treballa amb entitats de la comunitat lingüística i d’altres sectors per tal de recollir i processar grans quantitats de dades.

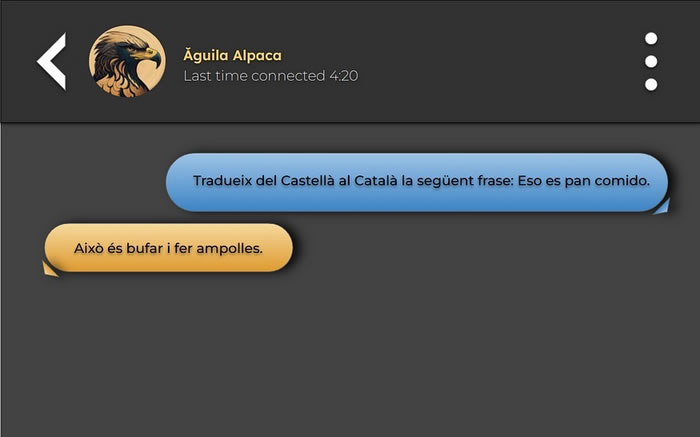

Els models de llengua són clau per al desenvolupament de noves aplicacions. Aina treballa en la generació i actualització d’aquests models, ja sigui mono o multilingües o multimodals.

També es col·labora en la implementació i inclusió de mòduls i llibreries per al català en entorns i plataformes de referència per garantir la correcta cobertura de la nostra llengua.

Uneix-te a Common Voice i forma part de l’esforç per posicionar el català com una de les llengües amb més recursos disponibles dins de l’àmbit digital.

Destacades organitzacions com Google han inspirat els seus models lingüístics com PaLM2 a través de les dades recollides en aquests repositoris.

Construcció de models pioners

La generació de models lingüístics entrenats és un pas fonamental per a la generació d’aplicatius basats en la intel·ligència artificial. Per això, l’objectiu d’Aina és l’entrenament de models que puguin suposar un progrés en termes de seguretat i eficàcia de resposta.

La generació dels models coneguts com a large language model (LLM)

és un procés progressiu que permet evolucionar exponencialment en la creació de nous models, reduint el cost i els recursos per entrenar nous models òptims. El model Salamandra 7B (disponible en 7B i 2B amb versions instruïdes) és el gran model de llenguatge desenvolupat en el marc del Projecte Aina i llançat pels investigadors de la Unitat de tecnologies del llenguatge del Barcelona Supercomputing Center (BSC).

El disseny dels LLM multilingües permet impulsar el sector de la intel·ligència artificial i el processament de llenguatge natural a Catalunya. També per optimitzar processos i internacionalitzar productes, millorar el servei de les administracions públiques, accedir a contingutsen català en l’àmbit digital i del sector de l’entrenament per part de la ciutadania , així com fomentarl’intercanvi de tecnologia i coneixement per part dels investigadors a la comunitat científica.